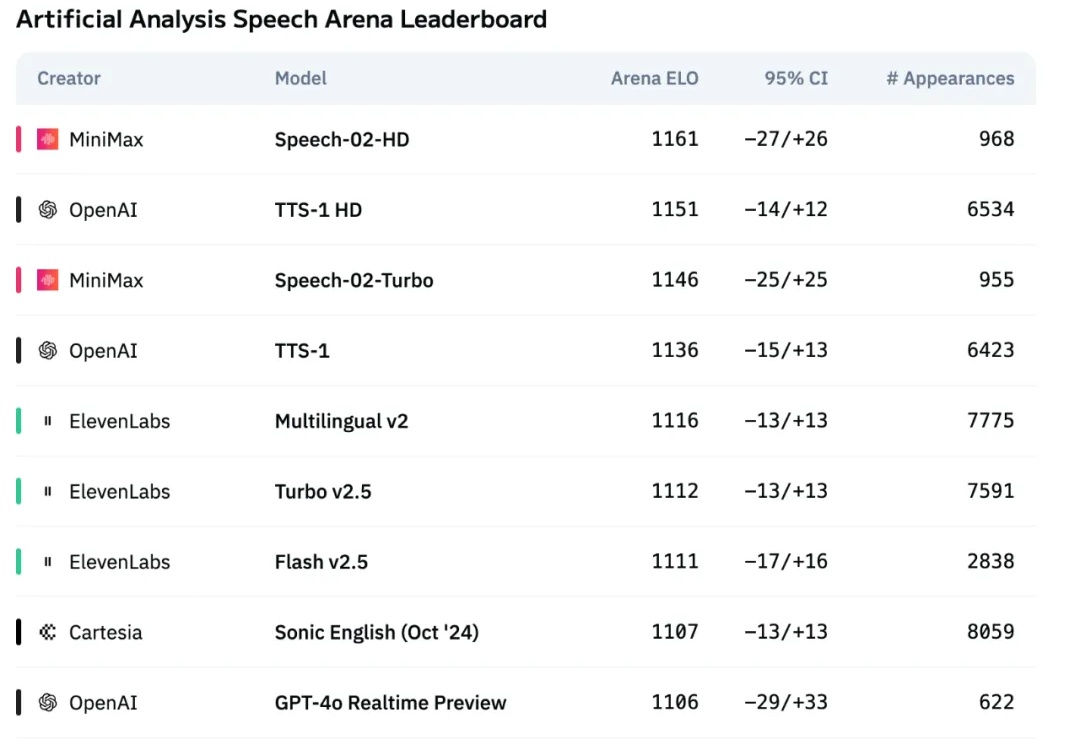

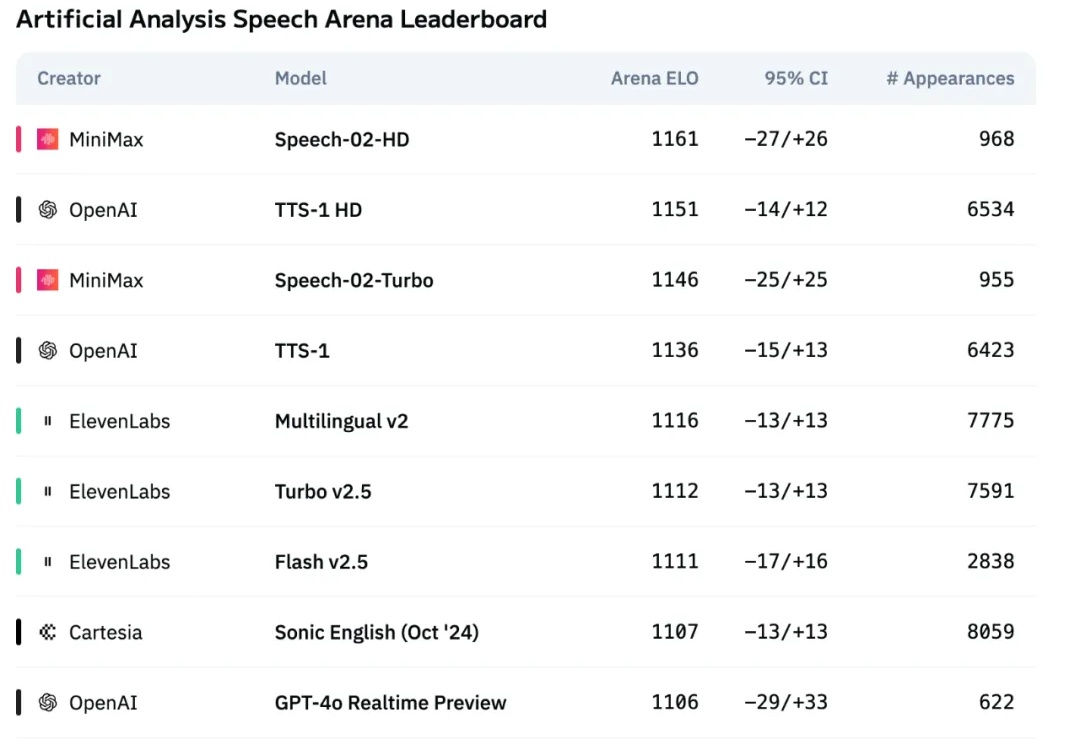

超越OpenAI、ElevenLabs,MiniMax新一代语音模型屠榜!人格化语音时代来了

超越OpenAI、ElevenLabs,MiniMax新一代语音模型屠榜!人格化语音时代来了国产大模型进步的速度早已大大超出了人们的预期。年初 DeepSeek-R1 爆火,以超低的成本实现了部分超越 OpenAI o1 的表现,一定程度上让人不再过度「迷信」国外大模型。

国产大模型进步的速度早已大大超出了人们的预期。年初 DeepSeek-R1 爆火,以超低的成本实现了部分超越 OpenAI o1 的表现,一定程度上让人不再过度「迷信」国外大模型。

热门法律AI 工具 Harvey 于 5 月 13 日在博客中宣布,将不再仅依赖 OpenAI 的基础模型,开始采用 Anthropic 和谷歌的基础模型。

2025 年 4 月的 AI 月报,你会看到:“评估(Evals)” 成为模型和 AI 产品开发的关键词;Google 继续提升 Gemini 模型能力的思路; OpenAI 的 GPT-4o 为什么变得谄媚,以及背后的问题;用户规模与模型能力提升关系不大?可能要有变化了

OpenAI 怎么敢的?

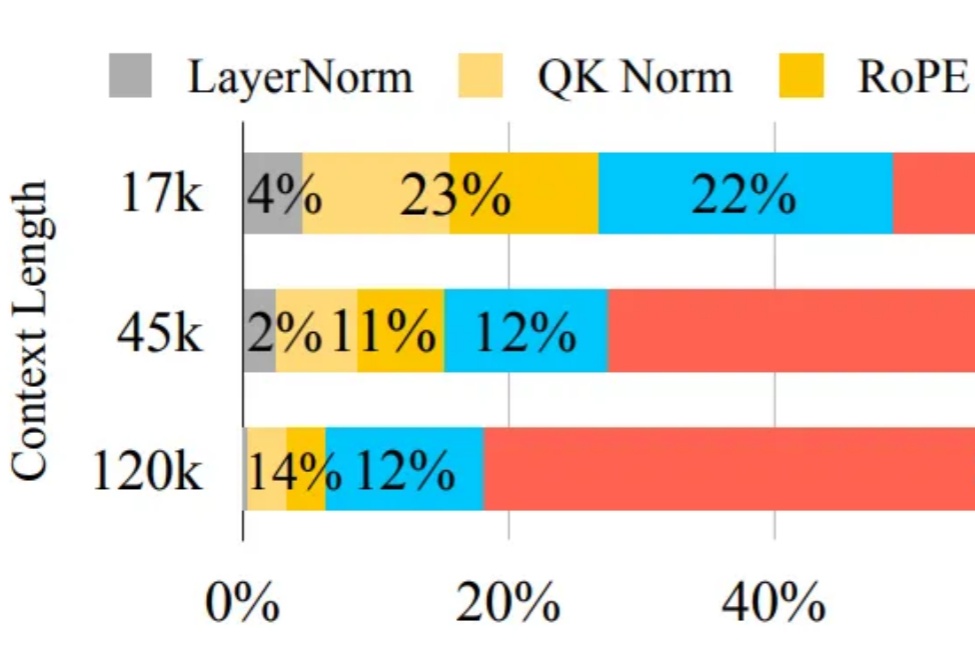

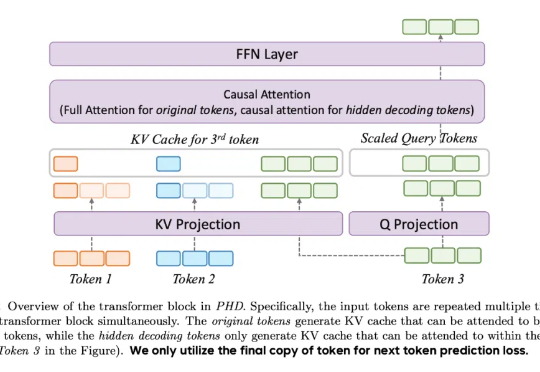

自 OpenAI 发布 Sora 以来,AI 视频生成技术进入快速爆发阶段。凭借扩散模型强大的生成能力,我们已经可以看到接近现实的视频生成效果。但在模型逼真度不断提升的同时,速度瓶颈却成为横亘在大规模应用道路上的最大障碍。

据内部人士透露,由 OpenAI 前训练后研究副总裁利亚姆·费杜斯创立的初创公司 Periodic Labs,已向潜在投资者表示希望以至少 10 亿美元的估值筹集数亿美元资金。这对于仅成立两个月的初创企业来说是一个相当高的估值。

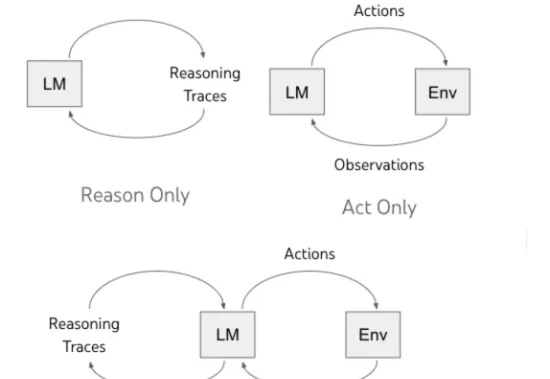

Agent 即一系列自动化帮助人类完成具体任务的智能体或者智能助手,可以自主进行推理,与环境进行交互并获取环境以及人类反馈,从而最终完成给定的任务,比如最近爆火的 Manus 以及 OpenAI 的 o3 等一系列模型和框架。

据 TechCrunch 报道,Recraft,这家神秘图像模型背后的初创公司,去年在一个备受尊敬的行业基准测试中击败了 OpenAI 的 DALL-E 和 Midjourney,已完成由 Accel 领投的 3000 万美元 B 轮融资。

最近,DeepSeek-R1 和 OpenAI o1/03 等推理大模型在后训练阶段探索了长度扩展(length scaling),通过强化学习(比如 PPO、GPRO)训练模型生成很长的推理链(CoT),并在奥数等高难度推理任务上取得了显著的效果提升。

自 OpenAI 发布 chatgpt 以来,业内除了技术公司、媒体公司比较关注其进展以外,还有一个行业比较关注,那就是战略咨询行业。尤其是最近 GPT-4o、Claude 3.7 Sonnet 为代表的最新大模型在数据分析、内容生成、编码和复杂推理方面展现出强大能力,与战略咨询工作的核心环节高度相关 。